El gobierno español anunció esta semana una importante revisión de un programa en el que la policía se basa en un algoritmo para identificar posibles víctimas reincidentes de violencia doméstica después de que los funcionarios plantearon dudas sobre la eficacia del sistema.

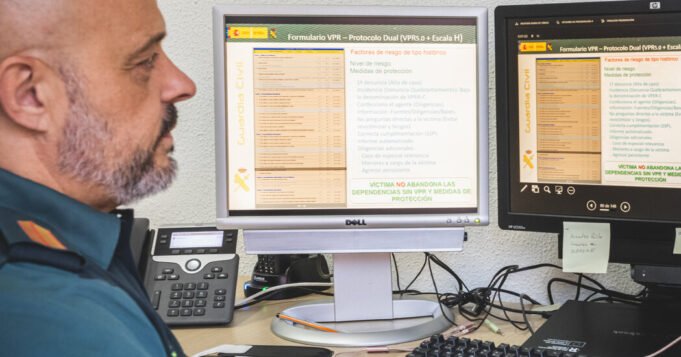

El programa VioGén requiere que los agentes de policía le hagan una serie de preguntas a la víctima. Las respuestas se ingresan en un programa de software que crea una puntuación, desde “sin riesgo” hasta “riesgo extremo”, para identificar a las mujeres más vulnerables a abusos repetidos. La puntuación se puede utilizar para determinar qué protección policial y otros servicios puede recibir una mujer.

Una investigación del New York Times del año pasado encontró que la policía dependía en gran medida de la tecnología y casi siempre aceptaba las decisiones del software VioGén. Algunas mujeres que el algoritmo consideró “sin riesgo” o “bajo riesgo de sufrir más daños” luego sufrieron más abusos, incluidas docenas que fueron asesinadas, encontró The Times.

Los funcionarios españoles dijeron que los cambios anunciados esta semana eran parte de una actualización planificada desde hace mucho tiempo del sistema introducido en 2007. Dijeron que el software había ayudado a los departamentos de policía con recursos limitados a proteger a las mujeres vulnerables y reducir el número de ataques repetidos.

En el sistema VioGén 2 actualizado, el software ya no puede marcar a las mujeres como libres de riesgos. La policía también tiene que ingresar más información sobre la víctima, lo que, según los funcionarios, conduciría a predicciones más precisas.

Otros cambios pretenden mejorar la cooperación entre las autoridades implicadas en la violencia contra las mujeres y, entre otras cosas, facilitar el intercambio de información. En algunos casos, las víctimas reciben planes de protección personalizados.

“El machismo está llamando a nuestras puertas y lo hace con una violencia que hace tiempo que no vemos”, afirmó este miércoles la ministra de Igualdad, Ana Redondo, en rueda de prensa. “Este no es el momento de dar un paso atrás. Es hora de dar un paso adelante”.

El uso que hace España de un algoritmo para gestionar la respuesta a la violencia de género es un ejemplo generalizado de cómo los gobiernos confían en algoritmos para tomar decisiones sociales importantes, una tendencia que se espera que aumente con el uso de la inteligencia artificial. El sistema ha sido estudiado como un modelo potencial para gobiernos de otros países que intentan combatir la violencia contra las mujeres.

VioGén se desarrolló con la creencia de que un algoritmo basado en un modelo matemático puede servir como una herramienta imparcial para ayudar a la policía a encontrar y proteger a mujeres que de otro modo podrían pasar desapercibidas. Las preguntas de respuesta sí o no incluyen: ¿Se utilizó un arma? ¿Hubo problemas económicos? ¿El atacante exhibió un comportamiento controlador?

Las víctimas consideradas en mayor riesgo recibieron más protección, incluidas patrullas periódicas en sus hogares, acceso a refugios y vigilancia policial de los movimientos de sus abusadores. Aquellos con puntuaciones más bajas recibieron menos ayuda.

En noviembre, había más de 100.000 casos activos de mujeres en España examinados por VioGén, y se consideraba que alrededor del 85 por ciento de las víctimas tenían bajo riesgo de volver a sufrir daños por parte de su abusador. Los agentes de policía en España están capacitados para anular las recomendaciones de VioGén si las pruebas lo justifican. Sin embargo, el Times descubrió que las evaluaciones de riesgos fueron aceptadas aproximadamente el 95 por ciento de las veces.

Victoria Rosell, jueza en España y ex delegada del gobierno que trabaja en temas de violencia de género, dijo que el gobierno necesitaba un período de “autocrítica” para mejorar VioGén. Dijo que el sistema podría ser más preciso si extrajera información de más bases de datos gubernamentales, incluidos los sistemas de salud y educación.

Natalia Morlas, presidenta de Somos Más, un grupo de derechos de las víctimas, dijo que acogía con agrado los cambios, que esperaba condujeran a una mejor evaluación de riesgos por parte de la policía.

“Es muy importante evaluar bien el riesgo de la víctima para salvar vidas”, afirmó Morlas. Añadió que era crucial mantener una estricta supervisión humana del sistema porque una víctima “necesita ser tratada por humanos, no por máquinas”.